Облачный ИИ: волков бояться — в лес не ходить?

Поговорим о доверии к облачному ИИ? Тому, что хостится на мощностях другой компании? К примеру, ChatGPT, GigaChat и даже наш DeepSeek. При обращении к ним свои запросы и данные вы передаете куда-то, чтобы получить какой-то результат. Именно эта неизвестность и пугает специалистов по информационной безопасности, ведь многие из них категорически против передачи каких-либо данных облачному ИИ. Правы ли они?

Меня зовут Илья Петухов, я работаю в компании Directum, вместе с нашей командой мы уже 8 лет проводим разработку ИИ-сервисов для бизнеса (крупнейшего, крупного, среднего и маленького) и не понаслышке знаем, какие стоп-факторы мешают постоянному использованию ИИ, какие эффекты дает применение этой технологии.

Осенью 2023-го мы провели исследование среди крупных и средних компаний: опрашивали ИТ-директоров, ответственных за цифровое развитие и генеральных директоров на предмет их готовности использовать ИИ в облаке для задач бизнеса. В итоге выяснили, что 85% из них к этому не готовы. Прошел год, мы снова провели такое же исследование и получили 81% скептиков, не готовых использовать искусственный интеллект в облаке.

Удивительно другое. Местами прослеживается такая тенденция: «Мы используем облачную инфраструктуру, пока ИБ об этом не знает, просто у нас выхода другого нет. Как ИБ запретит, мы перенесем…». А от некоторых слышали: «Я ChatGPT использую для анализа отчетности по продажам, а что, какие-то данные могут утечь?».

Если вы занимаетесь инфобезом и у вас есть волосы на голове, на этом моменте они могли зашевелиться. Да, это реалии рынка. Кто-то перестраховывается и не использует ничего, а кто-то понимает ценность технологий и идет на обдуманный (или не очень) риск.

Однажды на конференции Directum Алексей Викторович Лукацкий из Positive Technologies сказал: «Если ИБ все запрещает, это плохое ИБ. Надо искать пути решения». Поэтому давайте вместе разберемся, что именно происходит с данными, которые мы передаем ИИ в облаке. Разбираться будем на примере алгоритмов LLM, так как модели ML или OCR можно локально развернуть на любой телефон и ноутбук, что снимет вопрос безопасности.

Какие данные вообще передаются?

Сделаю ремарку: я не эксперт по информационной безопасности, я эксперт по ИИ.

Но чтобы обсудить с вами тему безопасности облачного ИИ, я предварительно провел серию интервью с сотрудниками ИБ и еще продолжаю это делать.

Выяснилось, что на самом деле ИБ не выступают жестко против облачного ИИ, они ограждают чувствительные данные, утечка которых может нанести финансовый либо репутационный вред компании.

К таким данным обычно относят финансовые показатели, производственные, и прочие фишки самой компании, которые дают ей преимущество на рынке. При этом ИБ спокойно разрешает пользоваться LLM-моделью в облаке для вещей маркетинговых либо продажных (например, сделать картинку, описать товар для маркетплейса и пр.).

Особняком стоят персональные данные, которые, согласно 152-ФЗ, нельзя передавать третьей стороне без согласия владельца.

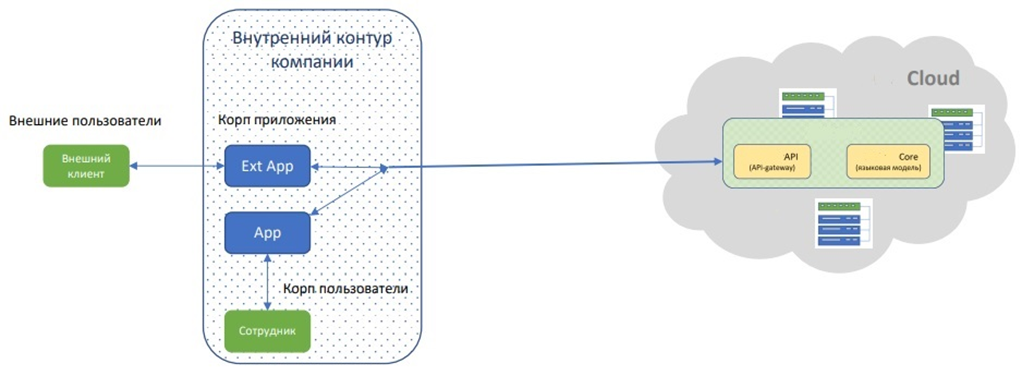

Разделив контент на «чувствительный» и не особо, предлагаю посмотреть на архитектуру одной из облачных LLM, чтобы понять, а попадают ли данные в чистом виде в модель ИИ, и как в ней организована безопасность.

Что находится в «черном ящике»?

Сразу скажу: я делаю выводы на основе открытой общей информации об архитектуре конкретной отечественной LLM-модели и информации, которую получил в ходе общения с представителями разработчика этой модели.

Рассмотрим схему, когда вы используете облачную LLM-модель через интеграцию по API. Попробуем повторить весь путь контента (промпт+контекст) по пути к LLM и обратно.

- Доступ к сервису API осуществляется c помощью REST API через HTTPS (безопасный протокол) либо с помощью gRPC. При этом используется протокол OAuth 2.0

- Сервис API находится в регионе Enablers, который предоставляется вендору LLM в рамках договора со стороны отечественного ЦОДа.

- Сам ЦОД включает многоуровневую систему защиты информации, соответствующую требованиям законодательства РФ и реализующую лучшие мировые практики кибербезопасности, что подтверждается аттестатами и сертификатами соответствия разнообразным требованиям (152-ФЗ УЗ-1, лицензии Роскомнадзора, ФСБ и пр.)

- LLM-модель является stateless (не запоминает свое состояние), поэтому данные, которые она получает, попадают только в оперативную память карты (технически очень сложно вычислить конкретную карту в кластере из тысяч карт), и после выдачи ответа стираются (не сохраняются в памяти).

- Сама модель не получает на вход текстовые данные, они преобразовываются в цифровые (эмбединги), и далее модель работает с ними и выдает на выходе цифровые данные, которые затем преобразовываются в токены (элементы слов, не слова).

Получается, контент идет по безопасному протоколу, не уходит за пределы страны, хостится в ЦОДе со всеми лицензиями и при обработке текст преобразовывается сначала в токены (да, да, те самые), а далее векторизуется в эмбединги. Сама LLM-модель на вход получает не текст, а преобразованный через матрицу цифровой контент.

При этом, чтобы восстановить обратно из векторных эмбедингов текст, надо иметь ту самую матрицу токенизации, которая есть у вендора. Это можно назвать «ключом к шифру». То есть в случае «взлома» или «утечки» к переданному мной контенту сложно будет восстановить либо получить доступ.

Допускаю, что мое описание может быть где-то поверхностным и с белыми пятнами. Поэтому делитесь в комментариях своими мыслями. Тема облачного ИИ явно не на одну статью.

Облако или локалка?

Складывается ощущение, что мы только приоткрыли крышку капота и взглянули на весь этот «двигатель» сверху. Но я думаю, многие читатели согласятся с тем, что использование облачного ИИ дает свои преимущества:

- облачные сервисы, как правило, оснащены системами мониторинга и предотвращения атак, которые могут обнаруживать и реагировать на подозрительное поведение в реальном времени;

- компании не устанавливают и не обслуживают серверы. Ниже вероятность технических ошибок и угроз безопасности, связанных с неправильной настройкой оборудования;

- использование облачных сервисов может сократить финансовые затраты на IT-инфраструктуру;

- в облаке обеспечиваются регулярные обновления и поддержка, что помогает пользователям оперативно решать их вопросы.

Я думаю, что при правильном использовании и понимании принципов работы облачных сервисов применение генеративного ИИ в облаке может быть не только безопасным, но и эффективным инструментом для многих организаций и пользователей.

Локальный вариант несет свои преимущества по части безопасности, но вместе с ними большие финансовые затраты и дополнительные сложности. Пока что малоразмерные LLM-модели не дают достойного для бизнеса качества.

Использовать облачные LLM точно стоит для ускорения развития технологий ИИ.

Похожие статьи

ваш личный спасательный круг

в цифровизации бизнеса

с полезными советами и новостями

от экспертов

Присоединяйтесь, будем на связи!

Комментарии 0