Информация и знания: невидимая грань

Всякий, кто в своей жизни сдавал экзамены, сталкивался с тем фактом, что информация и знания - разные вещи, и ощущал, насколько мучительным может быть процесс превращения одного в другого.

Введение

Информация и знания - не одно и то же

Всякий, кто в своей жизни сдавал экзамены, сталкивался с тем фактом, что информация и знания - разные вещи, и ощущал, насколько мучительным может быть процесс превращения одного в другого.

Важно отметить, что этот процесс - не механический. Даже в столь простом случае, как подготовка по учебнику, он должен включать не только запоминание, но и понимание.

Хорошая память может помочь кое-как сдать какую-нибудь общественную дисциплину, поскольку для этого часто достаточно просто воспроизвести усвоенную информацию «близко к тексту», но не слишком помогает сдавать экзамены по точным наукам, где на основе усвоенной информации нужно уметь решать задачи.

В компьютерной области проблема запоминания в общем решена - запомнить «наизусть» можно любые количества информации, но проблема получения из этой информации знаний остается и часто только усугубляется при росте объема данных.

Не пытаясь дать формальное определение, перечислим очевидные отличия знаний от информации. Мы рискуем впасть в противоречие с определениями знаний, принятыми в сфере так называемого искусственного интеллекта, однако это не страшно - нас интересуют не умозрительные конструкции, а чисто практические применения.

Итак, знания отличают от информации следующие свойства.

Структурированность. Знания должны быть разложены по полочкам - это ясно. Для печатных знаний (книг, журналов, равно как и для компьютерных хранилищ) это означает удобную архитектуру и прозрачность хранилища знаний, т. е. наличие ясных названий и заголовков, удобного представления структуры (оглавлений, рубрикаторов).

Удобство доступа и усвоения. Для человека - это способность быстро понять и запомнить или, наоборот, вспомнить; для компьютерных знаний - средства доступа, т. е. поиск, краткие аннотации к документам, индексы и проч.

Лаконичность. Лаконичность позволяет быстро осваивать и перерабатывать знания и повышает «коэффициент полезного содержания». В данный список лаконичность была добавлена из-за всем известной проблемы шума и мусорных документов, характерной именно для компьютерной информации - Internet и электронного документооборота.

Непротиворечивость. «Хорошие» данные/знания не должны противоречить друг другу, что очевидно или по крайней мере желательно. Однако для многих областей сбора знаний это изначально не так - на вход хранилища знаний может поступать разноречивая информация. Задача собирателя знаний обнаружить противоречия и разрешить их на этапе сбора знаний либо присвоить разным элементам данных различную оценку достоверности.

Оценка достоверности. Безусловно, усваивая или используя знания, хочется знать, насколько они достоверны. Хорошее хранилище знаний (учебник или база данных) должно иметь такую оценку для своих элементов. Но мы оценку достоверности в этой статье рассматривать не станем, так как будем для простоты считать, что для интересующих нас полнотекстовых задач все тексты - это несомненные факты.

Процедуры обработки. Знания нужны для того, чтобы их использовать - строить новые знания, решать задачи и проч. Одно из главных применений знаний - возможность передачи знаний другим и способность делать выводы на их основе. Для этого должны существовать процедуры обработки знаний. Способность делать выводы означает для машины наличие процедур обработки и вывода и подготовленность структур данных для такой обработки, т. е. наличие специальных форматов знаний.

Как отличить одно от другого?

Граница между информацией (данными) и знаниями нечеткая и зависит от воспринимающего субъекта. Слух или туманный намек может для умного человека стать знанием или источником знаний, а для не любящего думать и ворох информации останется просто информацией, без превращения в знания. Довольно часто можно встретить людей с хорошей памятью, но не имеющих привычки думать. Это показывает, что существует зависимость качества знаний от наличия и мощности процедур обработки.

Наилучший (вырожденный) пример информации, не превращающейся в знание, - иностранный язык. Наличие информации в иностранном тексте очевидно, однако в знание ее превратить невозможно, если не знать языка, или очень трудоемко, если пользоваться словарем.

Знакомый многим машинный переводчик - типичный пример автоматизированной процедуры извлечения знаний, дающей их существенный прирост, но при этом все равно крайне несовершенной. Переводчик-человек - пример более совершенной процедуры извлечения знаний.

Откуда берется необходимость в извлечении знаний?

Зачастую текст и на родном языке может быть настолько же трудным для извлечения смысла, как и текст на чужом – например, в силу смысловой загруженности, специальных терминов или большого объема.

Именно рост объемов компьютерной информации создает огромную потребность в извлечении знаний.

Вот хороший пример. Недавно автор вел переговоры с представителями одного из аналитических отделов российской спецслужбы, ситуация в котором довольно типична для сегодняшнего положения дел. Данный отдел получает в электронном виде до 10 Мбайт текстовой информации в день и должен дать свое заключение по ней. Десять мегабайт - это десять толстых книг, треть БСЭ или три «Войны и мира». А в отделе работает менее десяти аналитиков! Такая же проблема у отделов безопасности банков, аналитических служб частных компаний и проч.: информации слишком много, а обработать ее нужно обязательно в срок, и не дай Бог пропустить действительно критическую информацию.

Стоимость знаний

В разведывательном деле любой кусочек даже тривиальной информации может стоить очень дорого, а в обычной жизни, и особенно в Internet, знания стоят намного дороже, чем просто информация.

Информации в Internet масса, и почти вся она бесплатна, а вот знаний немного. Показательно, что существует довольно много служб в Internet, продающих структурированные данные - аналитические обзоры, собранную и препарированную прессу и т. п. Эти же данные в разбросанном виде, по частям, практически на 100% доступны в Internet кому угодно - бесплатно. Т. е. деньги берутся этими службами именно за работу по превращению данных в знания.

Естественно, если знания настолько важны и стоят так дорого, их добычу хотелось бы автоматизировать. И человечество уже продвинулось по этому пути.

Мы дадим здесь краткий очерк возможностей компьютера по извлечению знаний из текстов. Если в других статьях данного номера речь в основном идет об управлении готовыми корпоративными, «внутренними», знаниями, то мы поговорим о внешних, неструктурированных, данных, преимущественно текстовых, и превращении их в знания.

Организация информации и доступ к ней

Неверно думать, хотя к этому нас подталкивают творцы компьютерного мифа, что компьютеры - это мир совершенно новых идей и способов. По-настоящему новых идей всегда мало.

Нужно сказать, что и для организации доступа к текстовым данным человечество пока не придумало ничего существенно лучшего, чем оглавление с аннотациями глав (для поиска нужной информации «сверху») и предметный указатель - индекс по ключевым словам (для поиска нужного фрагмента непосредственно, «снизу»).

Второстепенным способом организации служат также ссылки, превратившиеся в компьютерную эпоху в гипертекст и World Wide Web, однако также придуманные довольно давно.

Хорошие университетские учебники служат именно эффективной передаче знаний и поэтому издавна включают все эти способы организации знаний. Наиболее близкий автору пример - классический трехтомный курс математического анализа Фихтенгольца, в котором поиск нужной леммы или теоремы занимает секунды.

Рассмотрим компьютерные способы организации знаний и доступа к ним подробнее.

Поиск

Поиск - это простейший способ доступа к текстовым данным, скорее подбор информации, чем извлечение знаний. Подробно поиск и поисковые машины обсуждались в прошлых номерах «Электронного офиса», а здесь мы только кратко перечислим основные «умения» поисковых машин: индексирование текстов и поиск по ключевым словам (по индексу); морфологический поиск - разбор и отождествление различных грамматических форм слов; логический язык запросов, позволяющий задавать условия на совместное вхождение ключевых слов в искомый документ; ранжирование по степени соответствия документа запросу.

Как видно из перечисленного, «классическая» поисковая машина умеет найти по запросу из нескольких слов все документы, в которые данные слова входят и предъявить их пользователю, что, кстати, может сделать и читатель печатного учебника, сравнив по предметному указателю, на каких страницах одновременно встречаются нужные ему термины.

Этой простой возможности при росте объемов текстовых баз становится совершенно недостаточно, и в последнее время поисковые машины начинают оснащаться средствами извлечения знаний. В первую очередь новшества появляются в поисковых машинах Internet, а затем постепенно проникают в средства поиска, входящие в корпоративные системы документооборота. Рассмотрим некоторые из этих новшеств.

Итеративный поиск: функция «найти похожие». Данная возможность позволяет постепенно уточнить запрос: указать на один или несколько найденных документов и попросить найти документы, повествующие «о том же». Выполняется такой поиск путем превращения документа в поисковый запрос (естественно, с определенной степенью «сжатия», так как запрос слишком большим быть не может). В Internet данная функция заявлена, например, поисковыми машинами AltaVista, HotBot, из российских - «Яндексом» (www.yandex.ru) и «Рамблером» (www.rambler.ru). Нужно сказать, что пока компьютерная наука продвинулась в этом вопросе не слишком далеко, и, как правило, работает данная функция плохо - часто находит совсем не то.

Поиск по выборке. Если по первому запросу поисковая машина нашла слишком много документов, то второй запрос с заданием дополнительных терминов можно провести только по ним, и тем самым уточнить поиск. Эта функция очень проста в исполнении (нужно только запомнить предыдущую выборку) и реализована в большинстве популярных машин Internet, включая российские «Яндекс» и «Рамблер».

Запрос на естественном языке. В отличие от формальных языков запросов с логическими операторами, запрос на естественном языке позволяет пользователю просто задать поисковой машине вопрос в свободной форме, как если бы он задавался человеку: «Как выйти замуж за миллионера?», «Скажи, где купить привод CD-ROM?» и т. д. Реализуется данная функция путем отбрасывания шумовых слов и выражений (как, скажи, где, за), выделения грамматической структуры запроса, подстановки синонимов и т. п.

Опять-таки, большинство поисковых машин декларирует подобную возможность, и пользователь действительно может ввести в строке запроса «естественный» набор слов, не разделяя их логическими операторами, однако зачастую эта функция фактически не работает. Например, «Рамблер» даже не отбрасывает «шумовых» слов и честно показывает все вхождения слов «как», «за» и подобных им, что, конечно, не имеет смысла и не нужно пользователю.

Тезаурусы. Тезаурусы (словари) служат для так называемого расширения запроса и включают синонимы, антонимы, родственные слова, «вышестоящие» и «нижестоящие» категории и понятия (военный-офицер-капитан).

Хотя использование тезауруса позволяет сделать поиск по-настоящему смысловым, пока большинство поисковых машин тезауруса не имеют, в том числе и упоминавшиеся российские машины. Трудно сказать, чем это вызвано, видимо, высокой стоимостью и сложностью лексикографической (словарной) работы.

Поиск типа «где». Как видно из сказанного выше, поисковые машины отыскивают все упоминания нужного понятия в документах. В последнее время стало ясно, что пользователя часто интересует не только поиск «чего-нибудь» где угодно и в любом количестве, но и наоборот - поиск одного конкретного места, где находится уже известная ему вещь: сервер Internet или домашняя страница. Чтобы удовлетворить эту потребность, начали появляться особые поисковые машины - службы имен, позволяющие по «обычному» имени ресурса Internet найти точное место, где он расположен. В настоящий момент таких известных служб две: калифорнийская служба имен RealNames (www.realnames.com) и российская Национальная Служба Имен (www.names.ru).

Обе эти службы позволяют вводить естественно-языковые имена в адресную строку программы просмотра (браузера) и сразу попадать на нужный сервер (например, набрав в адресной строке браузера «правительство», можно попасть на www.gov.ru), а также допускают использование различных синонимов для одного имени и задание неполных имен. Делается это путем поддержания базы имен и их соответствий обычным формальным адресам Internet, а также рассылки пользователям драйверов для распознавания естественных имен в браузере. (Чтобы воспользоваться одной из этих служб имен, пользователь должен скачать из сети или получить другим способом небольшую программу-драйвер, которая позволит его прогрмме просмотра отличать естественно-языковые имена.) Впрочем, данные службы дают возможность не только адресоваться к глобальной сети, но и создавать локальные службы естественно-языковых имен для внутренних сетей.

Очевидно, данный вид поиска будет постепенно включен в традиционные поисковые машины, в частности служба имен RealNames уже куплена поисковой службой AltaVista, так что теперь, если посетитель подобной поисковой машины введет в качестве запроса имя некоторой компании или ее торговую марку, первой в результатах поиска будет выдана именно ссылка на сервер этой компании.

Каталоги - лучше, чем поиск?

Ничто не может заменить оглавления, и в мире информационных технологий оглавления используются очень широко. В первую очередь это каталоги - т. е. рубрикаторы или классификаторы, организующие множества документов в деревья или целые заросли рубрик. В Internet такие каталоги известны не менее, чем популярные поисковые машины, прежде всего это знаменитый каталог Yahoo (www.yahoo.com).

Делается это просто (по крайней мере внешне это так выглядит): создатели классификаторов придумывают достаточно логичное и прозрачное дерево категорий, а затем наполняют его ссылками на документы и прочие ресурсы и составляют к ссылкам краткие аннотации.

Несмотря на наступление компьютерной эры, эта работа делается вручную, в частности, потому, что отнесение документа к нужным рубрикам - процесс в высшей степени неформальный. Например, каталог Yahoo непрерывно наполняют содержанием (ссылками и аннотациями) несколько тысяч человек, являющихся специалистами в той или иной области (т. е. категории документов). Впрочем, сейчас появляются средства автоматической классификации и аннотирования документов, о чем подробнее сказано несколько ниже.

Точно так же строятся каталоги и классификаторы вне Internet, в частности в правовых справочных базах данных, в корпоративных информационных системах и проч.

Каталоги предоставляют более удобный вид доступа к данным, так как они больше, чем поисковые машины, похожи на знания за счет своей структурированности. Однако для эффективного использования каталога пользователю нужно еще угадать принцип структуризации, который был применен при его создании и который зачастую существует только в головах авторов каталога. Поэтому для компенсации неудобств каталогов (если уж пользователь не знает, на какой ветке дерева «по логике» данного каталога лежит нужная ссылка, то не найдет ее никогда), каталоги в последнее время стали включать и средства поиска. И наоборот - поисковые машины стали снабжаться каталогами; в частности обзавелся своим тематическим каталогом ресурсов ветеран русского Internet «Рамблер».

Видимо, в дальнейшем эти два вида доступа окончательно переплетутся; вопрос только в том, как автоматизировать составление каталогов.

Аннотирование

Если помните, в старых книгах каждая глава начиналась с краткого изложения: «Робинзон видит человеческие следы, находит Пятницу, приучает его солить пищу, собирает первый урожай киви». Эти изложения (аннотации) выносились в оглавления, что лично мне представляется очень гуманным; жаль, что современные авторы так не делают.

Существующие каталоги также по возможности содержат аннотации для внесенных в них ссылок. Например, Yahoo содержит аннотированные ссылки на 500 000 Internet-страниц, разбитых на 25 000 категорий. Как говорилось выше, аннотации составляются вручную, скажем для сервера по экологическим проблемам - специалистом по экологии, а по медицинскому серверу - специалистом по медицине (а может быть, и по тому и по другому - одним и тем же специалистом по биологии, не знаю). Русский аналог Яху - Ау! - составляется точно так же, только специалистов в нем работает не тысячи, а в лучшем случае один-два десятка, аннотированных ресурсов - около 12 000.

Однако даже для каталогов по узким темам или географически ограниченным областям Internet ручная классификация и аннотирование начинают представлять собой проблему - количество информации в Internet растет «по экспоненте», сложность системы, количество связей, дублей и проч. также возрастает. Возникает потребность в автоматизации каталожной работы, в частности в автоматическом составлении аннотаций. Ниже в разделе «Автоматическое извлечение знаний» я расскажу о том, что сделано в этой области.

Гипертекст

Давно применявшиеся в книжном деле ссылки с возникновением компьютерных методов хранения текстов преобразовались в гипертекст. Наиболее разросшимся примером гипертекста является Всемирная Паутина.

Первое время на подобный способ организации данных возлагали очень большие надежды, считалось, что гипертекстовые структуры вытеснят линейные, что руководства, научные статьи и даже художественные произведения станут гипертекстовыми и интерактивными и будут писаться только в Сети и т. д. Однако сейчас постепенно становится ясно, что способ организации информации через ссылки, кроме удобства доступа (увидел ссылку - щелкнул мышью), имеет несколько существенных недостатков, среди которых низкая наглядность, не очевидность структуры, плохая запоминаемость пользователем пройденного пути и т. д. Как правило, основной результат сколько-нибудь длительной работы со сложным гипертекстом - ощущение, что ты «потерялся», и желание вернуться к началу пути. Дело в том, что средний человек с трудом запоминает вложенные структуры с уровнем вложенности более трех, а этим количеством уровней никогда не удается обойтись при создании крупных структур данных.

Справедливость сказанного видна из факта появления функции поиска и оглавлений (sitemap) на всех крупных серверах Internet.

Тем не менее способ организации гипертекстовых связей сам по себе как дополнительное средство доступа достаточно удобен и также допускает автоматизацию при создании больших массивов знаний, о чем подробнее будет рассказано далее.

Автоматизированное извлечение знаний

Многие задачи извлечения знаний поддаются автоматизации, и кое-что уже сделано. Традиционно это направление компьютерной науки носит громкое рекламное имя «искусственный интеллект», хотя по сути представляет собой набор вполне простых, технических приемов программирования и прикладной лингвистики.

История искусственного интеллекта - история несбывшихся обещаний. В начале-середине восьмидесятых годов начался бум так называемых экспертных систем, которые должны были уметь сами опрашивать экспертов в той или иной области знаний (например, медицине), а затем отвечать на вопросы профанов и даже давать пояснения, если что-то в ответе непонятно. Крах этой отрасли искусственного интеллекта наступил к концу 80-х, когда стало ясно, что не то что построить автоматическое извлечение данных их эксперта, но и даже создать вручную «базы знаний» не удается.

Несколько сохранившихся на рынке экземпляров экспертных систем представляют собой скорее кашу из топора - так много обычных чисто технических «прилад» написано вокруг так и не заработавшей по-настоящему технологии.

В конце позапрошлого года начался новый бум, под именем «добыча данных» - data mining. В прессе поднялся невероятный шум, было обещано создание систем, которые, самостоятельно «обнюхав» данные, будут делать нетривиальные выводы. Например, обещали по данным о продажах автоматически обнаруживать связи типа «покупатели памперсов на 80% совпадают с покупателями детских молочных смесей», что позволило бы владельцу данных сэкономить кучу денег на рекламе своих товаров.

Судя по тому, что шум утих, это общее увлечение вылилось в создание нескольких относительно простых, но работающих систем, а остальные создатели шума принялись надувать новый мыльный пузырь (Internet, каналы вещания, виртуальные частные сети и проч.).

Через некоторое время лопнувшие мифы возвращаются в виде простых систем, которые делают почти то, что обещалось, но уже без претензии на интеллектуальность.

Извлечение простейших знаний

Поиск особых контекстных явлений. Существующие поисковые системы не слишком умны. Даже имея текстовую базу, содержащую всю нужную информацию, можно так и не найти ее. Вот простейший пример: как отыскать документы, содержащие дату 19.07.1998? Речь здесь идет не о поиске документов с такой датой создания, это-то как раз просто, а о содержащих упоминания данной даты. Для подавляющего большинства поисковых систем - это невыполнимая задача.

Во-первых, сама по себе данная дата, как правило, представляет для них три разных слова - 19, 07 и 1998. Во-вторых, поисковая система не сможет «вспомнить» и найти синонимы даты - 19 июля 1998 года, девятнадцатое июля 98 года и т. д.

А ведь для журналиста, сотрудника спецслужбы или бизнес-аналитика могут быть наиболее важны в тексте именно даты, суммы прописью и числами, номера телефонов и автомобилей в разных написаниях, коды ГНИ, адреса, полные имена (ФИО), имена фирм и продуктов, торговые марки - те осмысленные контекстные явления, имеющие разнообразные формы, которые не обнаруживаются и не отождествляются при индексации текстов и не находятся при обычных «логических» запросах.

Реализуются подобные поисковые возможности путем написания специальных «распознавателей» на каждый тип контекстных явлений и подключения их на этапе индексирования текстов.

К сожалению, пока в популярных поисковых машинах Internet нет подобных возможностей. Системы поиска, применяемые в корпоративных системах документооборота, тоже пока этого не умеют. Однако, видимо, поисковые средства такого рода появятся в скором времени, поскольку есть потребность: в частности одна из самых больших сетевых библиотек Dialog Corp., www.dialog.com, дает средства поиска по множеству таких явлений, в том числе по известным и неизвестным (!) именам компаний и торговых марок.

Фактографические запросы. Кроме прямого поиска по тексту, пусть даже особых «вкраплений», хотелось бы, чтобы система отвечала на так называемые фактографические вопросы, например «Где купить самый дешевый подержанный «Фольксваген» не старше пяти лет?» Особенно это актуально для электронных энциклопедий, служб технической поддержки, систем помощи и сетевых библиотек.

Для того чтобы система могла отвечать на подобные вопросы, и поисковый запрос, и сами текстовые данные должны обрабатываться более тонким образом.

Действительно, в отличие от обычного поиска вхождений терминов запроса в документы, для того, чтобы электронная энциклопедия могла ответить на вопрос «Какая самая высокая гора в мире?» или «Кто были цари России в прошлом веке?», нужно не только правильно препарировать запрос (например, отождествить понятие «прошлый век» с интервалом цифровых значений дат), но и просмотреть множество статей, сравнить результаты поиска по ним и объединить их в разумный ответ.

Задача, как легко видеть, сложная, и в настоящее время практически не существует программ, позволяющих задавать фактографические запросы к текстовым базам данных.

Очевидно, работы в данном направлении ведутся, и, как всегда, маркетинг далеко опережает результаты, однако до появления доступных и дешевых технологий обработки фактографических запросов пока далеко. Хорошим примером неудачной реализации этой идеи может служить так называемый Answer Wizard, входящий в состав системы помощи во многих современных приложениях Windows.

Языковой доступ к базам данных. Доступ к базам данных на обычным естественном языке является давней мечтой человечества, и не раз уже объявлялось, что эта задача решена. Как правило, всякий раз это оказывалось рекламным трюком.

Действительно, имея тщательно собранную и стоившую значительных средств базу данных по покупателям определенных товаров, хотелось бы иметь возможность спросить ее, например: «Кто из наших заказчиков дважды покупал один и тот же товар в течение месяца?» или «Сколько покупателей потратили за один раз сумму больше 1000?» Более того, многие начинающие пользователи при знакомстве с базами данных очень удивляются, что этого сделать нельзя, ведь именно этого они ожидали от компьютерных технологий!

К сожалению, пока такие вопросы приходится задавать программисту, обслуживающему базу данных, а уж он переводит их на стандартный Структурированный язык запросов (SQL), поддерживаемый всеми популярными базами данных, и выдает результаты в специальных формах отчетов. Круг типичных вопросов обычно довольно быстро исчерпывается - до следующего пользователя.

Язык SQL создавался специально для таких запросов, и для англоговорящего пользователя его синтаксис напоминает синтаксис естественного языка. Однако сходство это скорее внешнее, и задание запросов на SQL - это достаточно квалифицированный труд.

Фактически, задача естественно-языкового интерфейса к базам данных состоит в переводе с обычного языка на формальный язык SQL и значительно проще машинного перевода на другой естественный язык.

С развитием средств обработки естественного языка, систем машинного перевода и средств поиска по запросу на естественном языке задача несколько упростилась, и можно надеяться, что в ближайший год-два проблема будет все же решена. В частности, уже упоминавшаяся компания Junglee (www.junglee. com) уже объявляет, что через ее виртуальную базу данных можно задавать запросы такого «естественного вида» ко многим базам данных, выставленным в Internet, например к банкам кадров.

Автоматическое построение гипертекстов

Когда нужно создать обширную систему помощи для сложной программы или систему справки, скажем, по атомной электростанции, расставить руками ссылки практически невозможно. Возникает потребность в автоматическом определении мест, где ссылки необходимы, в выявлении связей между документами и расстановке ссылок. Такие инструменты существуют, в том числе и российского производства (в частности, функцию расстановки гиперсвязей включает система HyperMethod петербургской фирмы AI Labs - veronica.etu. ru/ailab, а также система TextAnalyst - www.textanalyst.ru). Автор, к сожалению, никогда ими не пользовался, а только наблюдал их демонстрацию на выставках. Тем не менее есть сильное подозрение, что системы эти работают пока не слишком хорошо, поскольку, по словам их создателей, они не применяют сколько-нибудь развитых лингвистических средств, например синтаксического и морфологического анализа (как если бы капитан корабля по принципиальным соображениям отказывался пользоваться картой).

В любом случае с точки зрения функциональности системы автоматически расставленные гипертекстовые ссылки легко заменяются автоматической же встроенной поисковой системой, позволяющей щелкнуть по любому слову или словосочетанию и найти все его вхождения в данный набор документов (так сделано в большинстве современных электронных словарей и энциклопедий).

Машинное аннотирование

Как уже говорилось выше, потребность в автоматическом составлении аннотаций для поисковых машин и каталогов довольно высока и со временем увеличивается. Держатели каналов вещания, списков рассылки новостей и корпоративных систем документооборота также начинают испытывать интерес к автоматизации этого процесса. Зачастую не только требование дать возможность быстрого просмотра содержания, но и желание не нарушать авторские права заставляет заменять полные тексты документов аннотациями.

Частному пользователю также может пригодиться возможность быстро просматривать большие объемы документов, используя их краткие аннотации.

Как составляется аннотация? Прежде всего нужно сказать, что фактически в во всех известных системах машинное аннотирование является экстрагированием - программа не «пересказывает» смысл текста, а просто извлекает из него те фрагменты, которые считает важными, и объединяет их в аннотацию. Важность конкретного предложения определяется по различным параметрам, в частности по так называемым маркерам важности (например, «в заключение нужно сказать, что...»), количеству содержательных слов в нем и т. д.

В наиболее развитых средствах аннотирования учитывается также зависимость предложений друг от друга с тем, чтобы не вносить в аннотацию обрывки, начинающиеся, например, со слов «К тому же...», «В-третьих...» и т. п. Чтобы аннотация получилась связной, программа подбирает группы взаимосвязанных (взаимозависимых) предложений, а затем «склеивает» их, для большей связности немного изменяя на стыках.

Однако развитый синтаксический разбор и применение тезаурусов (словарей синонимов), которые могли бы значительно улучшить качество аннотирования, пока что дело будущего.

Что имеется на рынке? Сейчас существует довольно много готовых систем, осуществляющих машинное аннотирование. В частности, в состав Microsoft Word 95 входит функция для автоматического аннотирования английских текстов. В русской версии Word средства аннотирования для русских документов нет.

Для аннотирования текстов на русском языке существует компонент системы ОРФО 5.0, выпускаемой компанией «Информатик» (www.informatic.ru), и программа «Либретто 1.0» компании «МедиаЛингва» (www.medialingua.ru), выполняющая аннотирование и для русских и для английских документов. Обе эти программы встраиваются в Microsoft Word. Пробную версию «Либретто» можно получить по адресу: www.medialingua.ru.

В сети Internet автоматически построенные аннотации на русском языке можно увидеть и оценить, запустив поиск по известному новостийному серверу «ИнфоАрт» (www.infoart.ru) с помощью установленной на нем поисковой машины «Следопыт», включающей средство аннотирования документов.

Кроме того, доступные по бесплатной подписке новости того же сетевого издательства «ИнфоАрт» рассылаются в виде заголовков с краткими аннотациями, автоматически созданными с помощью средства GoldenKey компании Textar.

Качество этих систем читатель может оценить сам; нужно сказать, что и так само по себе различное для разных программ качество аннотации обычно еще и «плавает» от документа к документу - так как гладкость и содержательность аннотации сильно зависит от самого документа.

Автоматическая классификация документов

Автоматическая классификация документов - еще одно направление искусственного интеллекта, заявленное двадцать лет назад. Сейчас впервые стали появляться средства, выполняющие эту задачу.

Для чего нужны средства автоматической классификации? Средства классификации требуются везде, где имеется набор рубрик и большой входной поток документов. К таким случаям относятся каталоги Internet, каналы вещания (push-channels), прежде всего новостийные службы, службы электронной почты и внутренние каталоги государственных организаций и корпораций, имеющих большой входной поток документов и желающих разложить их по полочкам или создать индивидуальные профили доставки информации для групп пользователей.

Во всех этих случаях нужно быстро «разбросать» новые документы по имеющимся рубрикам. Как это делается?

Списки ключевых слов. Самый простой способ сортировать входной поток документов по нужным категориям (рубрикам) - задать для каждой рубрики набор ключевых слов, которые позволяют отнести документ к данной рубрике. Именно так и построены наиболее простые системы классификации, в частности системы фильтрации электронной почты наподобие средств фильтрации Microsoft Outlook.

Список ключевых слов служит в этом случае простым семантическим образом рубрики.

Как и многие другие простые способы, с реальными документами этот способ работает далеко не во всех случаях. «Зашитые» в программу или вносимые пользователем ключевые слова могут иметь в реальности синонимы, различные формы, могут быть действительно важными или не значить ничего именно в данном контексте. Кроме того, для языков с высокой изменчивостью слов - русского, немецкого и проч. - этот способ работает совсем плохо.

Поисковые запросы как основа классификации. Более «умный» способ - превратить списки ключевых слов для каждой рубрики в поисковый запрос, передать поисковой машине и применить его ко множеству новых документов. Таким образом можно получить более аккуратно ранжированный список документов, «близких» данной рубрике. Кроме того, можно подключить к классификации морфологические модули и словари синонимов - все то, что уже разработано для поисковых машин.

Недостатки данного способа коренятся в том факте, что в описанном виде он также применим только для фиксированного набора рубрик и для созданного вручную множества ключевых слов. Подобные системы существуют, однако неудобны и дороги.

Довольно типичный случай «тяжелой» системы классификации данного типа, когда сама система стоит 15-20 тыс. долларов и еще примерно столько же заказчику нужно потратить на ручное составление специалистами исполнителя заказного дерева рубрик, а также семантических образов для каждой рубрики.

В последнее время появляются системы классификации нового поколения, которые все это делают сами, быстро и не намного хуже человека.

«Истинная» автоматическая классификация. Уже существуют программы-классификаторы, которые избавляют пользователя от рутинной и сложной работы и составление семантических рубрик берут на себя. Делается это так: администратор каталога, канала вещания или системы документооборота указывает программе рубрики и отнесенные к ним « обучающие» выборки документов. Программа выделяет в обучающих текстах значимые термины (слова и словосочетания), приводит их к словарным формам, составляет распределение терминов по рубрикам и документам, подсчитывает различительную силу каждого термина для данной рубрики и составляет семантические образы из наиболее различительных терминов. (Различительная сила термина - вероятность того, что при обнаружении данного термина в документе этот документ относится к данной рубрике. Самый простой способ для вычисления различительной силы термина таков: нужно частоту появления термина в данной рубрике разделить на число его появлений во всем множестве документов. Если термин почти не встречается вне рубрики, данное число будет близко к единице, а в противоположной ситуации - к нулю.)

В дальнейшем, при классификации входного потока, программа может использовать поисковые запросы или иным способом вычислять смысловую близость документа к рубрикам.

Как ни удивительно, классификация по таким семантическим образам работает гораздо лучше, чем по составленным человеком спискам ключевых слов.

В процессе работы системы системный администратор может время от времени «освежать» ее - перестраивать семантические образы, применяя вновь полученные документы, чтобы уточнить их, благо делается это автоматически и быстро.

Существуют и так называемые «научные» способы классификации документов, основанные на нейронных сетях, методах кластеризации, отображения документов в формальные многомерные пространства и т. д. В частности, так работает система TextAnalyst компании НПИЦ «Микросистемы» (на сервере www.textanalyst.ru можно скачать демонстрационную версию), а также пример кластеризации газетных публикаций и других документов на сервере компании «Гарант-Парк» (www.park.ru/websom) - демонстрация метода WEbSOM для кластеризации документов.

Читатель может сам составить мнение о качестве классификации этих систем, а автор может добавить, что данные методы обычно имеют заведомые ограничения, так как не учитывают лингвистических данных, рассматривая слова и тексты как формальные последовательности знаков.

Апофеоз классификации. Для пользователей, не имеющих времени или средств даже на построение самой системы рубрик, предлагаются программы, выполняющие автоматическое построение системы рубрик по неупорядоченному вороху документов. Делается это так: программа выделяет наиболее важные термины, нормализует их (приводя к «именительному падежу») и составляет заключение об иерархии терминов по их форме и распределению в тексте. Например, термин «контракты на нефть» описывает более широкую рубрику, чем «срочные контракты на нефть». Дерево рубрик с наборами документов и предполагаемыми названиями предлагается пользователю (администратору), который и утверждает его после необходимых модификаций.

Что сейчас имеется на рынке? Посмотреть, какие системы автоматической классификации предлагаются на рынке, можно в Internet по адресам: компания Autonomy (www.agentware.com) - система классификации, основанная на статистических принципах, «МедиаЛингва» (www.medialingua.ru/products/tecnolo/classify/classify.htm) - автоматическая классификация для текстов на русском и английском языках и автоматическое построение рубрик, «Гарант-Парк» (www.park. ru/websom) - демонстрация кластеризации документов, система классификации на сервере компании WiseWire (www. wisewire.com), компания Junglee (www. junglee.com) - так называемая виртуальная база данных для Internet.

Предлагаемые этими компаниями технологии значительно отличаются, но в общем и целом работают. На некоторых серверах можно скачать демонстрационные версии. Главное - понимать, что идеального решения не бывает, и не брать на веру излюбленных утверждений разработчиков о понимании программой «смысла» текста и т. п.

Перспективы

Сейчас уже можно предположить, какие принципиально новые системы извлечения знаний появятся в ближайшем будущем. Ниже я коротко коснусь трех интересных возможностей.

Доклад на заданную тему

Средства поиска и сжатия информации подошли к тому рубежу, когда немного осталось до создания системы, составляющей по заданию пользователя доклад на конкретную тему по определенной области (базе данных или Internet). Более или менее ясно, как это сделать технически, имея «умную» поисковую машину и уже существующие средства смыслового сжатия текстов и обнаружения смысловых дублей. Степень доверия пользователя к таким докладам будет определяться практикой (статистикой использования) или степенью доверия начальника к своим референтам.

Извлечение фактов

Как известно, американская разведка в годы Второй мировой войны шпионила за Германией и ее союзниками не только с помощью засылки секретных агентов, но также с помощью изучения открытой немецкой прессы.

Был разработан метод так называемого «окна фактов», с помощью которого из каждой публикации извлекались только несомненные факты, часто совершенно тривиальные и неинтересные. Например, из предложения «Новый директор Apple Стив Джобс заявил, что компания стала возрождаться и в 1999 год перейдет с прибылью 100 млн. долларов» можно извлечь только тот несомненный факт, что в 1998 году Джобс был директором Apple.

Оказалось, что сопоставление подобных «атомарных» фактов может дать неожиданные новые знания. Например, по газетным публикациям о Джобсе можно автоматически составить описание его жизненного пути (в терминах атомарных фактов), а заодно провести анализ прибыльности возглавляемых им компаний в зависимости от его прихода и ухода.

Насколько мне известно, впоследствии этот же метод был применен для слежки за развитием самой Америки, в результате чего на свет появилась очень интересная книга Дж. Нэсбитта (Naisbitt, J. Megatrends: Ten New Directions Transforming our Lives), описывающая десять главных тенденций в развитии США в 70-80 годах, которые были не видны простым глазом, но стали совершенно очевидны при заполнении и сравнении «окон фактов».

Можно предположить, что современные поисковые системы от простой индексации слов в документах Internet перейдут именно к сбору фактов. Технически это не очень сложно, а тривиальных фактов в Internet чрезвычайно много.

Поскольку факты, собираемые подобным

образом, имеют простую структуру, их легко превратить в знания и производить по

ним автоматический логический вывод, например «X - продукт компании Y

Виртуальный собеседник

Следующим шагом по развитию средств доступа к знаниям должны стать виртуальные собеседники. В очень многих областях человечеством накоплено достаточно знаний, чтобы можно было организовать диалог с виртуальным собеседником, например поговорить с виртуальным «сотрудником» службы технической поддержки (если накоплено достаточно наиболее частых вопросов и ответов) или с электронным воплощением Сократа, диалоги которого у Платона и Ксенофонта также дают обширный материал для организации виртуального общения.

Собственно организация диалога с машиной не представляет собой сверхъестественной сложности, что было доказано знаменитой программой «Элиза» - виртуальным психотерапевтом, созданным в 80-х годах Джорджем Вейценбаумом. Весь вопрос - в правильной подготовке данных и их объеме.

Я думаю, первые виртуальные собеседники появятся в ближайшие три-четыре года и вызовут новый шум в прессе и всплеск мифов вокруг возможностей и границ применимости искусственного интеллекта.

Но это уже вопрос не технический, а нравственный, как справедливо пишет Дж. Вейценбаум в своей книге «Возможности вычислительных машин и человеческий разум», поэтому здесь я позволю себе закончить.

Источник: Игорь Ашманов

Похожие статьи

ваш личный спасательный круг

в цифровизации бизнеса

с полезными советами и новостями

от экспертов

Присоединяйтесь, будем на связи!

Комментарии 1

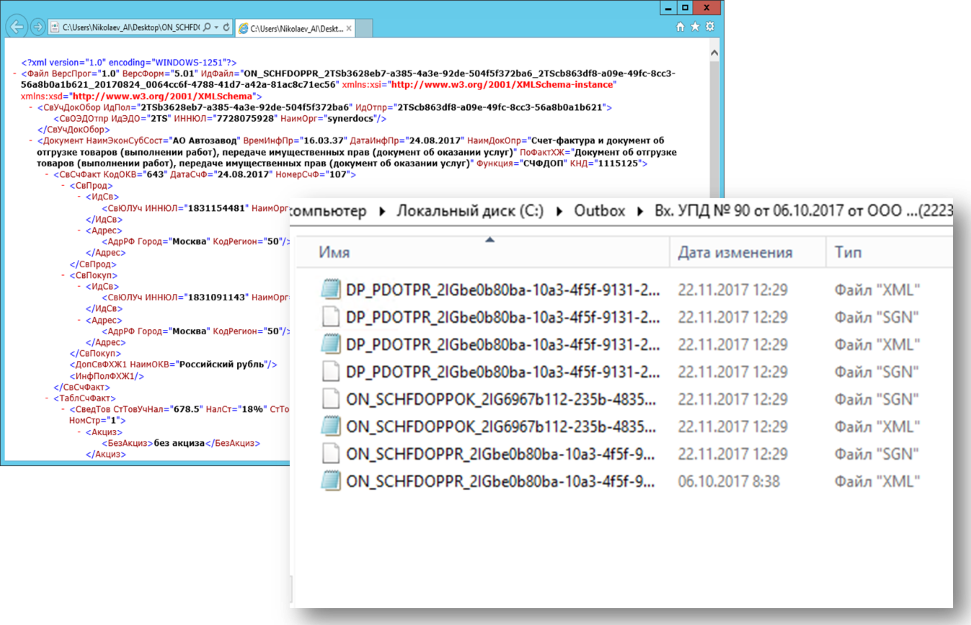

Извлечение знаний - интересная тема и создано достаточно программ, работающих в данной области. Класс программ DM (добыча знаний) напрвлен на из влечение структурированной информации в виде знаний. Форма представления знаний - вот направление исследований многих разработчиков ПО. Структуры знаний преставляют от форм систем выводе, до семантических и неронных сетей. Проблема одна - все знаний для восприятия должны быть осмыслены внаиболее удобной форме. Для детей это форма игр и сказок, а для взрослых - разная, связанная с профессиональными особенностями. В Директуме знания хранятся только в программном коде. Пора ISBL сделать XML языком.